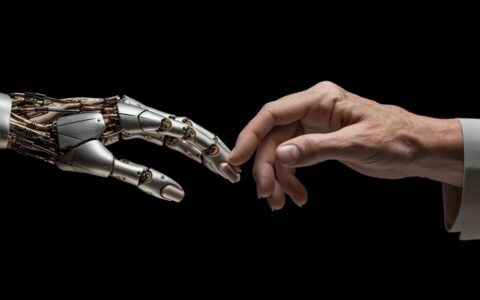

openai最近宣布了其新的网络爬虫。该机器人将收集公开可用的数据,用于训练ai模型,业务声称将以透明和负责任的方式完成。

根据openai的发布文档,网络爬虫将进行过滤,以消除需要付费墙访问的来源以及个人身份信息(pii)或违反公司法规的材料。根据gpt的发明者的说法,让机器人将有助于提高未来ai系统的准确性和能力。

这一革命性的举措不仅有望提高人工智能模型的精度、能力和安全性,而且还引发了关于数字时代数据伦理、所有权和使用方面的深入辩论。尽管openai承认它利用互联网来训练像gpt-4这样的大型语言模型,但这似乎是解决从其他人网站获取数据的道德问题的半生不熟的人生就是博尊龙凯时的解决方案。

gptbot 访问可以受到限制

在承认数字环境中固有的多样性的同时,openai使能够选择gptbot与其网站交互的数量。网站管理员可以完全限制 gptbot 的访问权限,或者通过对其机器人文件进行谨慎.txt更改来指定它可以浏览的目录。

gptbot的推出为网站管理员和内容提供商提供了一个新的视角,为探索他们的数字领域提供了一个窗口。借助大量文档,网站管理员可以分析 gptbot 与其网站的交互,并且他们可以使用标准的 robots.txt 协议控制访问。

访问控制是一种简单的技术,需要包括以下指令:

- 用户代理:gptbot disallow: /

以下结构可用于更精细的方法,允许更具选择性的访问:

- 用户代理: gptbot allow: /directory-1/ disallow: /directory-2/

- 平衡:legal, ethical, and ownership considerations

最近,openai申请了“ gpt-5”的商标,这意味着该公司正在训练其下一个版本的gpt-4,根据各种消息来源,它将接近agi,这一直是该公司的目标。gptbot无疑将协助组织从互联网上收集其他数据,以便训练此模型。另一方面,该公司也停止使用其ai分类器来识别gpt生成的文本。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun248271.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重