,采用了c-rlft(强化学习微调)ai人工智能技术进行微调,展现了强大的性能和出色的泛化能力,在多项基准测试中,openchat表现优异,超越了chatgpt。该模型在7b大小的模型上运行,令人惊叹地能够在24gb ram的消费级gpu(消费级显卡主要为家用设计,产品支持的重点是保证硬件功能正常,可能无法深入处理软件层面的兼容问题。)上取得优越的效果,不亚于更大规模的gpt模型。以下是关于openchat的一些主要特点、性能和工作原理如下:

主要特点:

- 微调效果出众: openchat通过c-rlft的ai技术微调,可以从已有的对话数据和反馈中改进模型的表现,甚至能够从错误中学习。在多个基准测试中,与其他同类的开源语言模型相比,openchat展现出色的性能,特别是在遵循指令和泛化能力方面。

- 适应消费级gpu: openchat的7b模型可以在消费级gpu上运行,展现了出色的计算效率,无需专业级显卡支持。这使得该技术更为普及,为广大用户提供了更为便捷的使用体验。

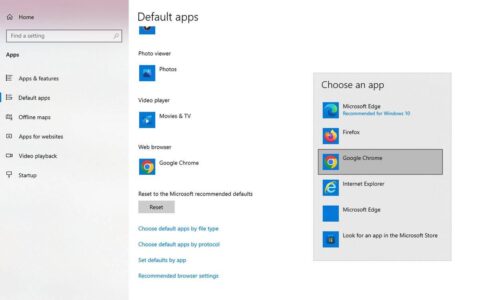

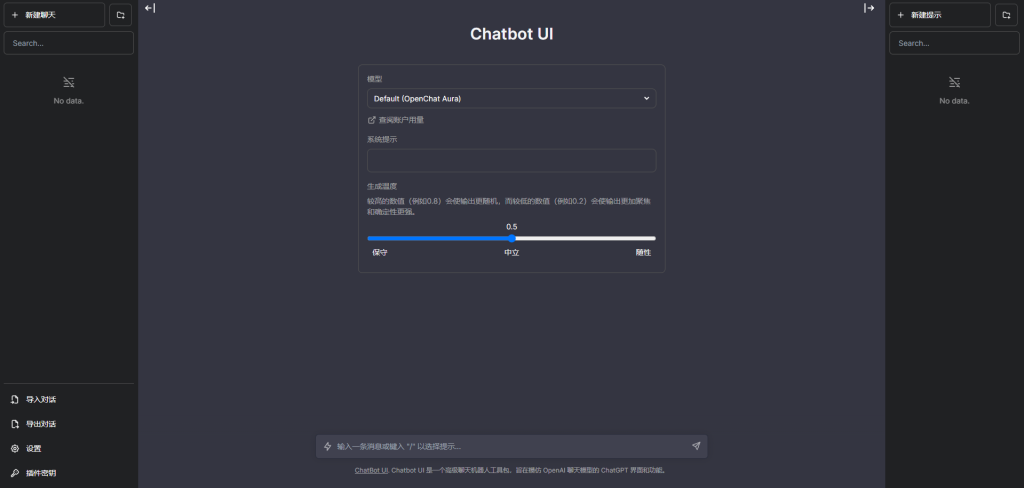

- web ui界面: openchat提供了一个web ui界面,方便用户与模型进行交互。这种用户友好的设计使得用户能够轻松使用和配置openchat,提高了交互的便捷性。

性能和评估:在基准测试方面,openchat-3.5的7b模型表现出色,平均得分为61.6,超越了同期chatgpt(march版本)的61.5。与x.ai 330 亿参数的grok的比拼中,openchat-3.5-7b也取得了令人瞩目的效果。

工作原理:

- 预训练语言模型: openchat的核心是一个大型的预训练ai语言模型,通过分析大量文本数据学习语言结构、语法和语义。

- 微调方法(c-rlft): openchat采用c-rlft方法进行微调,利用条件化强化学习,能够高效地处理混合质量的数据。

- 类条件策略学习: openchat学习了类条件策略,可以根据输入数据的类型来调整响应,使得在处理不同类型的输入时更加灵活和有效。

- 单阶段监督学习: openchat使用单阶段监督学习方法,通过最大化奖励和减少与参考策略的差异来优化模型,提高学习效率并减少训练中的错误。

详细链接:https://huggingface.co/openchat/openchat_3.5

github网址链接:https://github.com/imoneoi/openchat

论文网址链接:https://arxiv.org/pdf/2309.11235.pdf

在线体验网址链接:https://openchat.team

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun268094.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重