谷歌发布了一个用于视频生成的大语言模型videopoet,这个有点意思。这个是一个专注于视频生成的多模态 llm 。支持各种视频生成功能以及音频生成,让 llm 来指导完整的视频生成工作,几乎全能了,不只是生成还有各种视频编辑、声音生成。

同时这种方法还能解决现在视频模型无法生成动作幅度过大视频的问题。演示视频是用videopoet生成的浣熊故事。

具体功能:

❖支持从视频内容中获取信息自动生成环境音频,这个很强。

❖通过纯文本提示生成视频,视频输出长度是可变的,同时可以响应文本中的动作和风格。

❖支持从图像生成视频。

❖支持将视频转换为别的风格,主要通过深度和光线信息进行控制。

❖通过对视频最后1 秒的条件化可以生成很长的长视频。

❖支持对输入视频通过文本控制生成更长的后续视频。

❖图像生成可以对生成视频对象的动作进行文字控制。

❖支持各种类型的镜头控制。

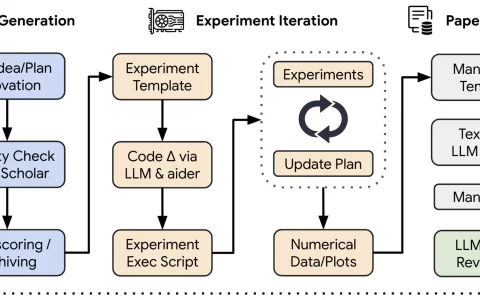

实现方法:

与其他基于扩散方法的模型不同,videopoet 将多个视频生成功能集成到单个 llm 中,并利用 llm 训练基础设施提高效率。 videopoet 使用多个分词器处理视频、图像、音频和文本数据,可以生成可转换回可视化表示形式的标记。它可以生成纵向定位(portrait orientation)适合短格式内容的视屏,并通过链接后续预测片段来演示如何生成更长时间的视屏。

评估结果:

评估过程中人们选择了24-35%的videopoet示例,认为其比竞争模型更好作为提示,而竞争模型的选择率为8-11%。

评分者还更喜欢41-54%的videopoet示例,认为其动作更有趣,而其他模型的选择率为11-21%。

收起

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun271565.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重