ai21 推出了新的 1.5 模型家族,包括 jamba 1.5 mini 和 jamba 1.5 large,这些模型采用了创新的 ssm-transformer 架构。

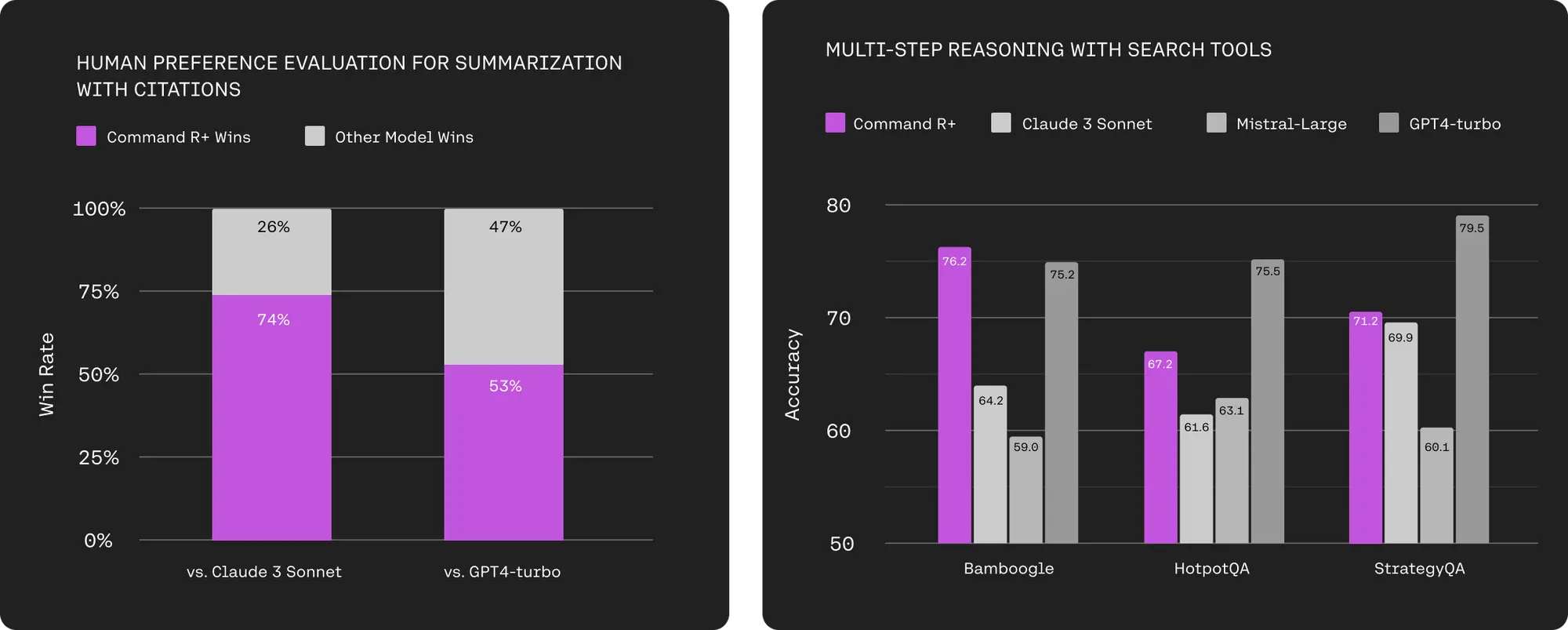

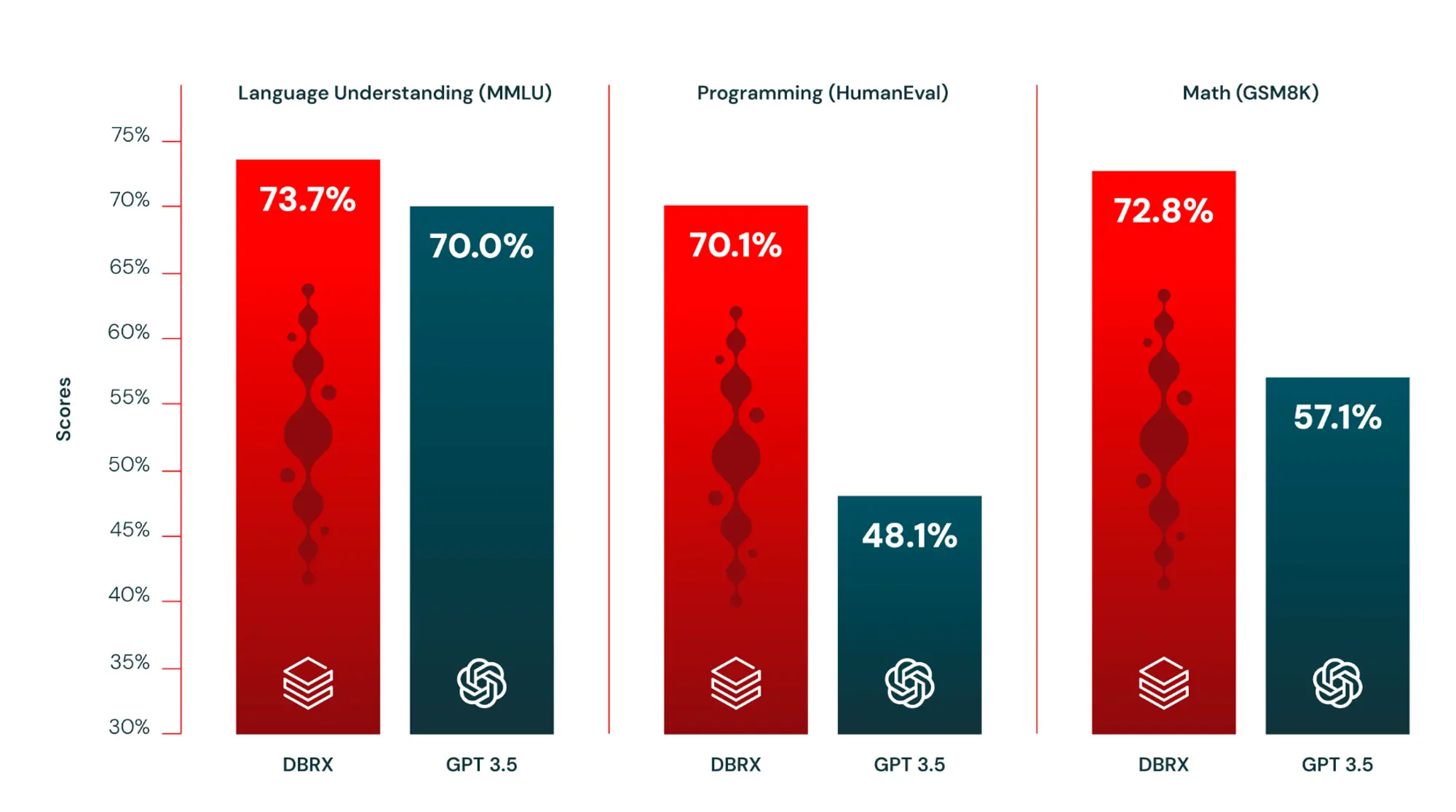

这是第一次非 transformer 架构的模型追上市场上领先的其他 transformer 模型。

- 256k 的有效上下文窗口

- 长文本速度快 2.5 倍,同尺寸最快

- 本地支持结构化的 json 输出、函数调用

- 除了英语之外支持多种其他语言

他们还开发了一个专门针对 moe 模型的量化方案expertsint8。这项技术提供了四个优势:

- 速度快,量化过程只需几分钟;

- 不依赖于校准,这一有时不稳定的过程通常需要几个小时或几天;

- 仍然可以使用 bf16 来保存大规模激活;

- 允许 jamba 1.5 large 适配单个 8 gpu 节点,同时利用其 256k 的完整上下文长度。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun299406.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重