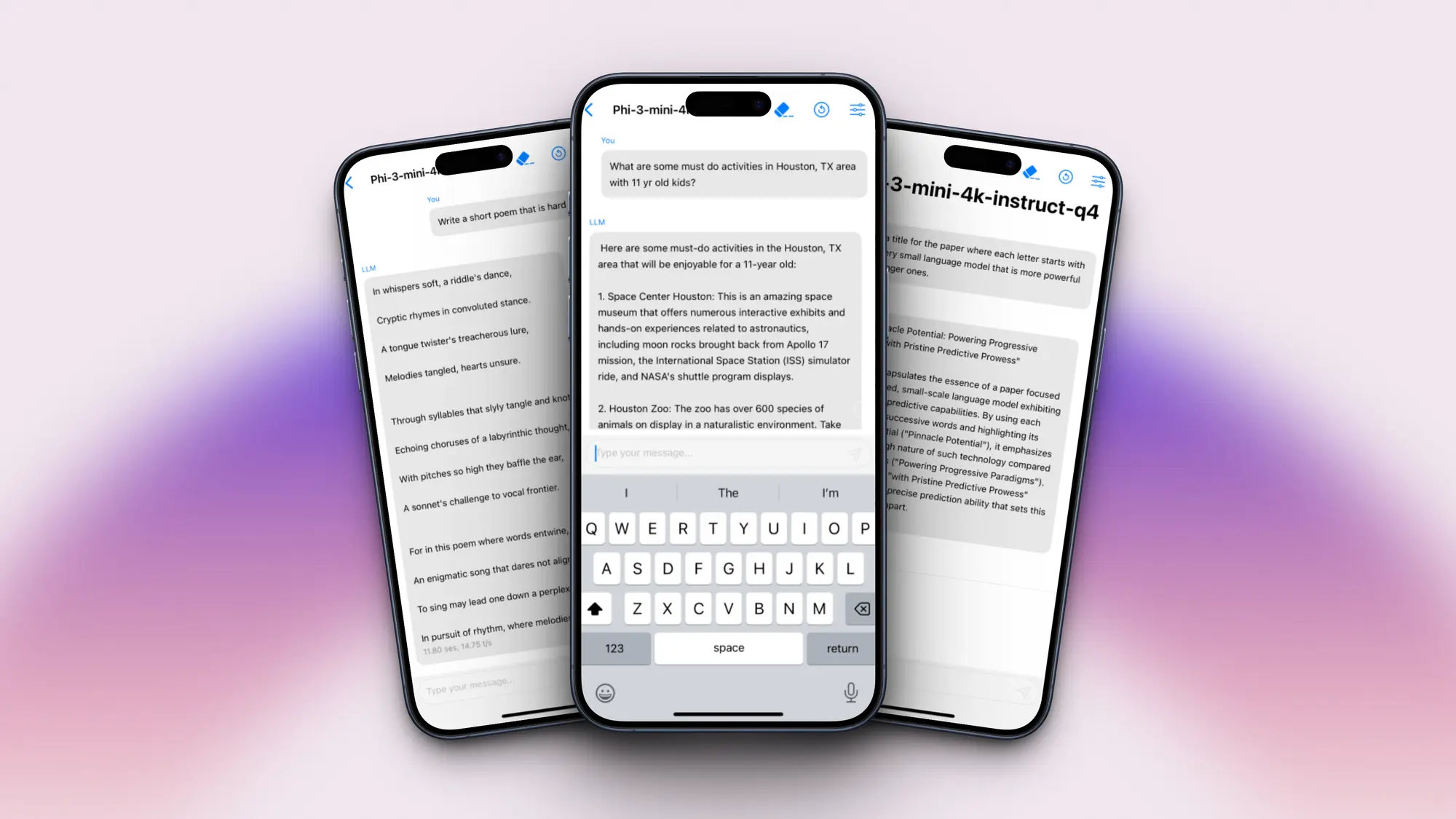

微软发布 phi-3-mini 模型,4 位量化之后可以部署在 iphone 14 上,只占用 1.8g 内存,每秒输出 12 个 token 。模型能力上跟 mixtral 8x7b 和 gpt-3.5 差不多。

这几天这个模型被部署到了各个苹果设备上,甚至是 vision pro。

详细介绍:

一个新型语言模型 phi-3-mini,该模型拥有38亿参数,高达3.3万亿 token。

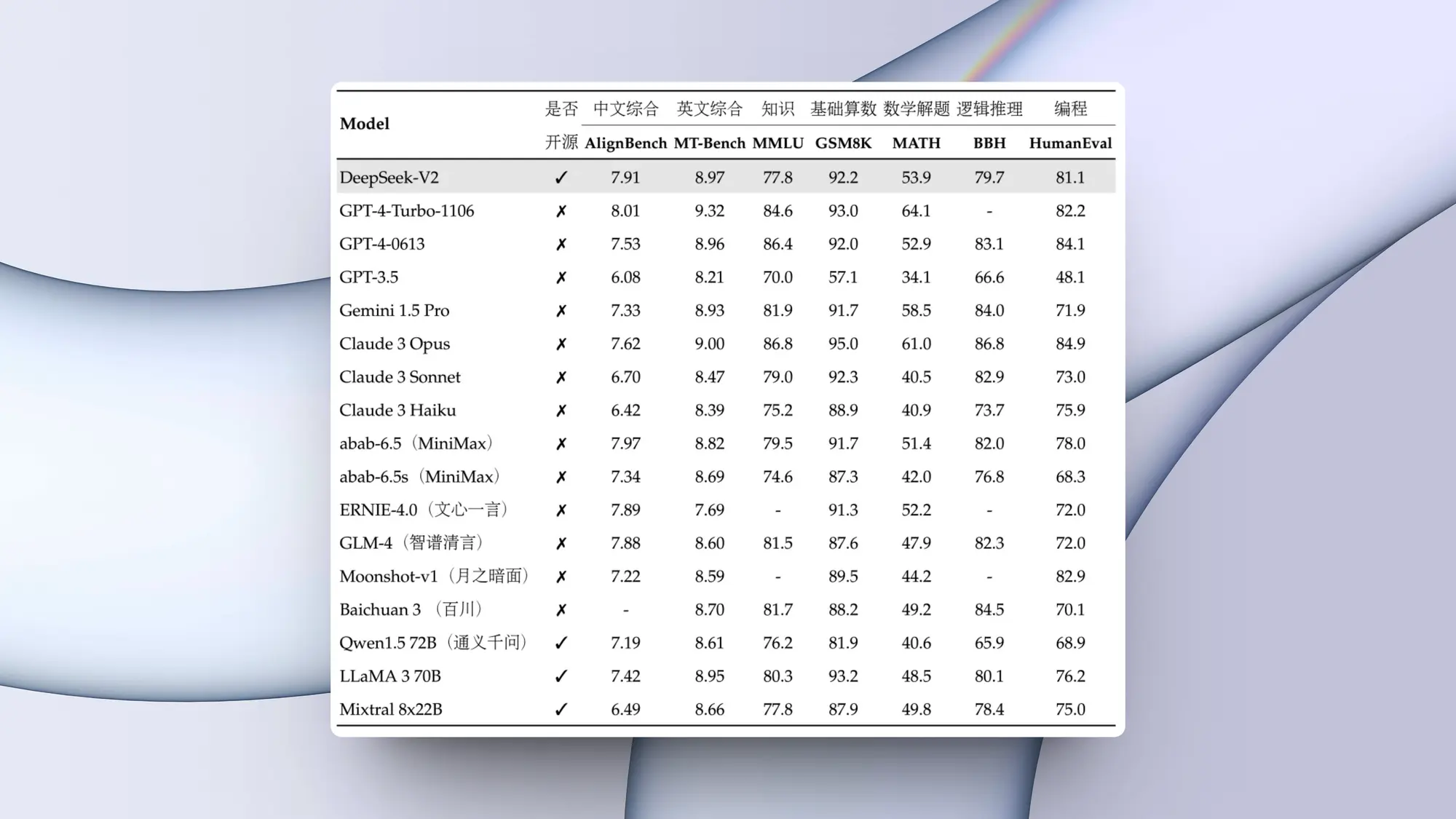

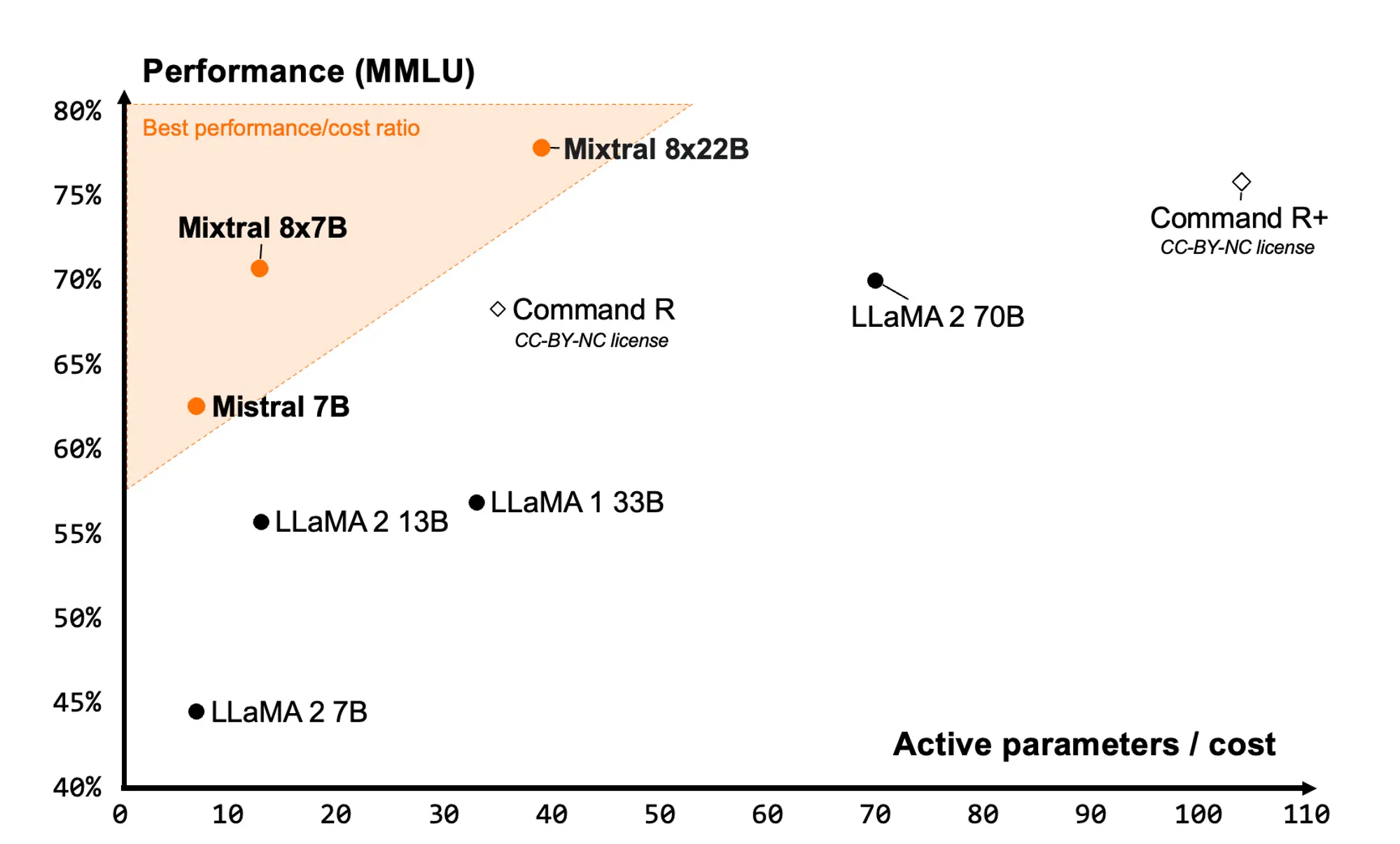

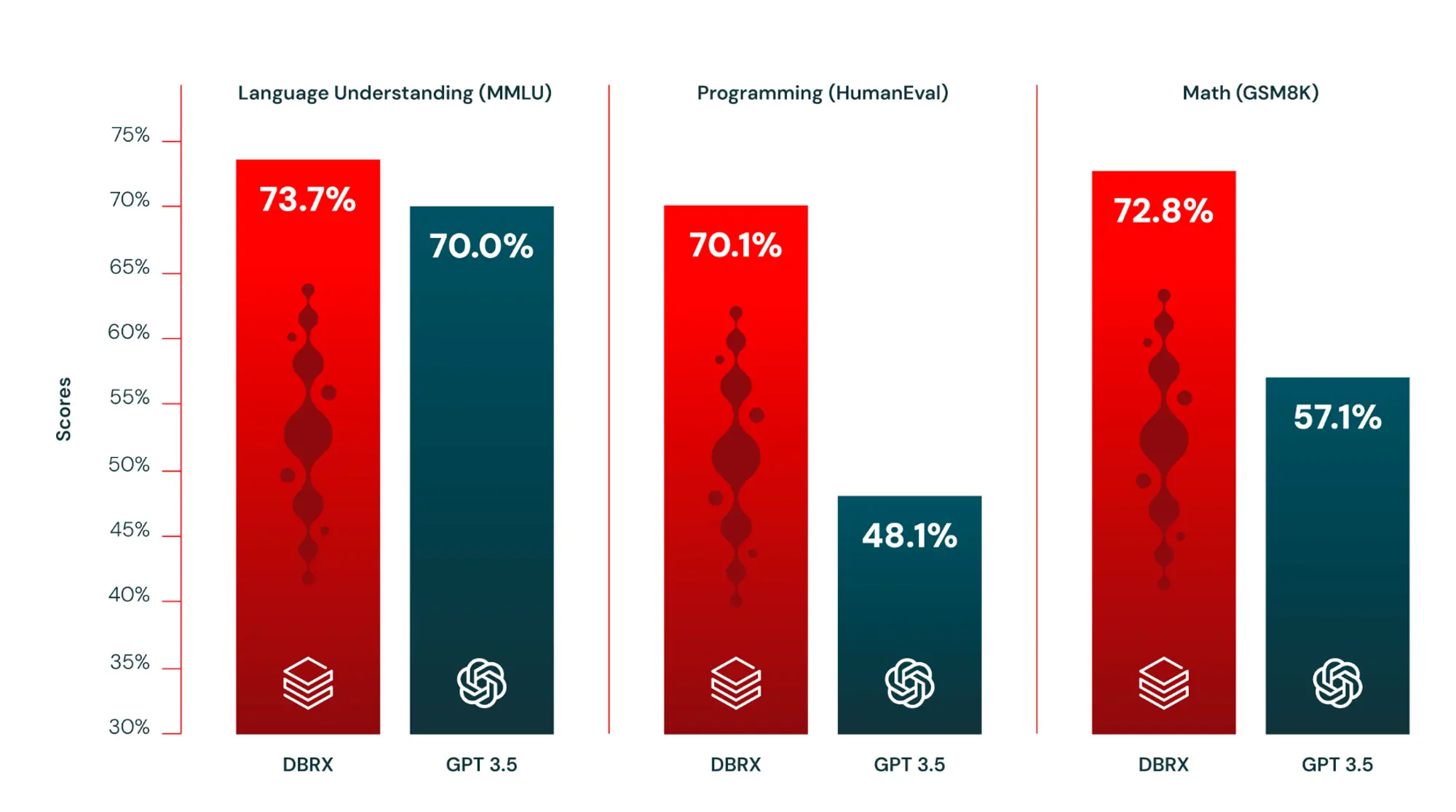

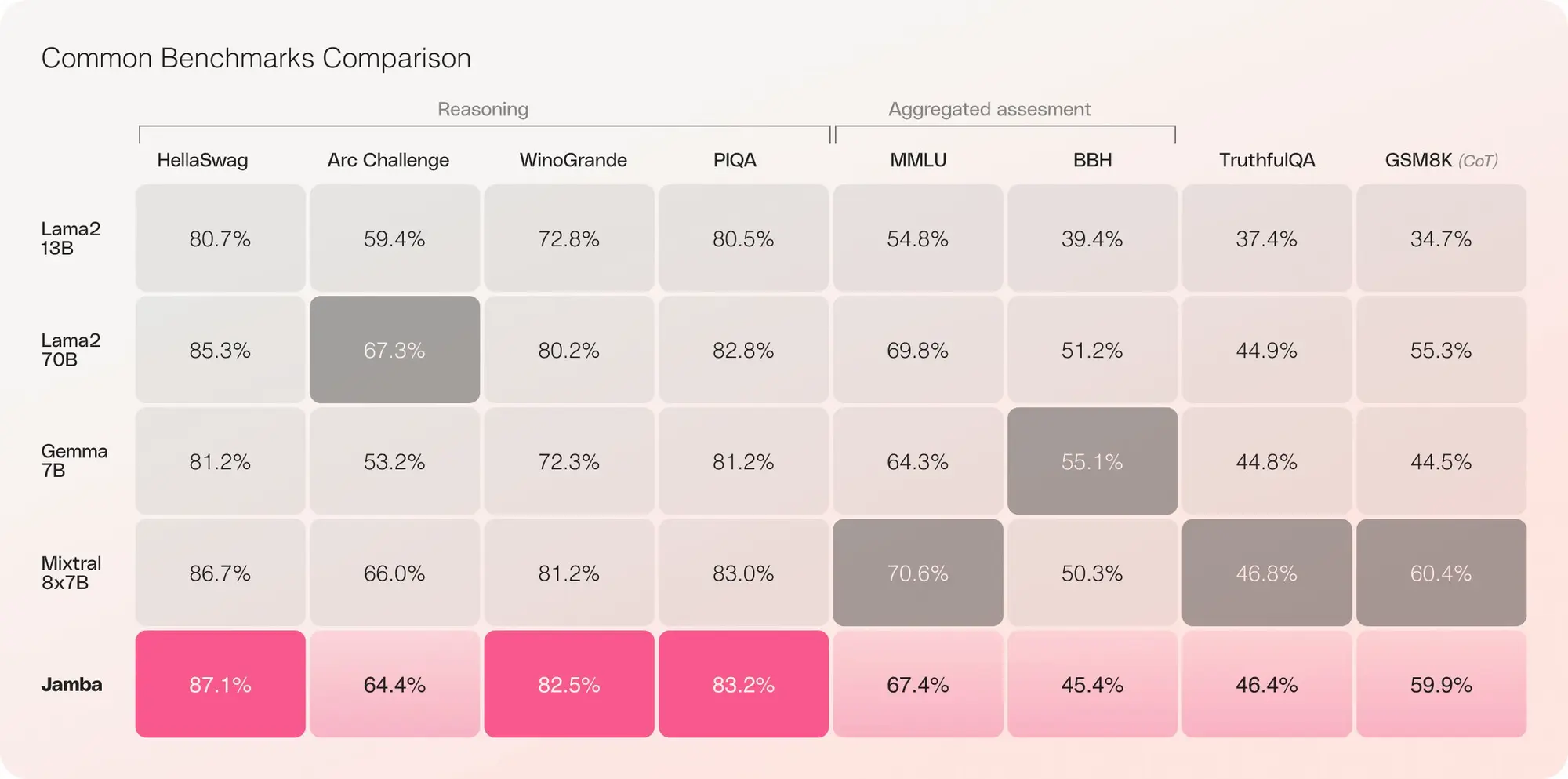

根据学术基准和我们的内部测试,phi-3-mini 的整体性能与 mixtral 8x7b 和 gpt-3.5 等大型模型相当(例如,在 mmlu 达到69%,在 mt-bench 测试中得分为8.38),但其体积小到足以部署在手机上。

这种创新归功于我们的训练数据集,它是 phi-2 所用数据集的扩大版本,包括了经过严格筛选的网络数据和合成数据。此外,这个模型还进一步优化了其鲁棒性、安全性和适应聊天的格式。

还初步展示了在训练达4.8万亿 token 的情况下,使用7b和14b参数的模型(名为 phi-3-small 和 phi-3-medium)所取得的成效,这两个模型的性能均显著优于 phi-3-mini(例如,在 mmlu 测试中分别达到75%和78%,在 mt-bench 测试中分别得分为8.7和8.9)。

模型下载:https://huggingface.co/microsoft/phi-3-mini-128k-instruct-onnx

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun295854.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重