之前效果不错的 chatglm模型发布了第二代。他们的6b 可以部署在消费级设备上的。

chatglm2-6b 是开源中英双语对话模型 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,chatglm2-6b 引入了如下新特性:

- 更强大的性能:基于 chatglm 初代模型的开发经验,全面升级了 chatglm2-6b 的基座模型。

- 更长的上下文:将基座模型的上下文长度(context length)由 chatglm-6b 的 2k 扩展到了 32k,并在对话阶段使用 8k 的上下文长度训练,允许更多轮次的对话。

- 更高效的:基于 技术,chatglm2-6b 有更高效的推理速度和更低的显存占用:在官方的模型实现下,推理速度相比初代提升了 42%,int4 量化下,6g 显存支持的对话长度由 1k 提升到了 8k。

- 更开放的协议:chatglm2-6b 权重对学术研究完全开放,在获得官方的书面许可后,亦允许商业使用。

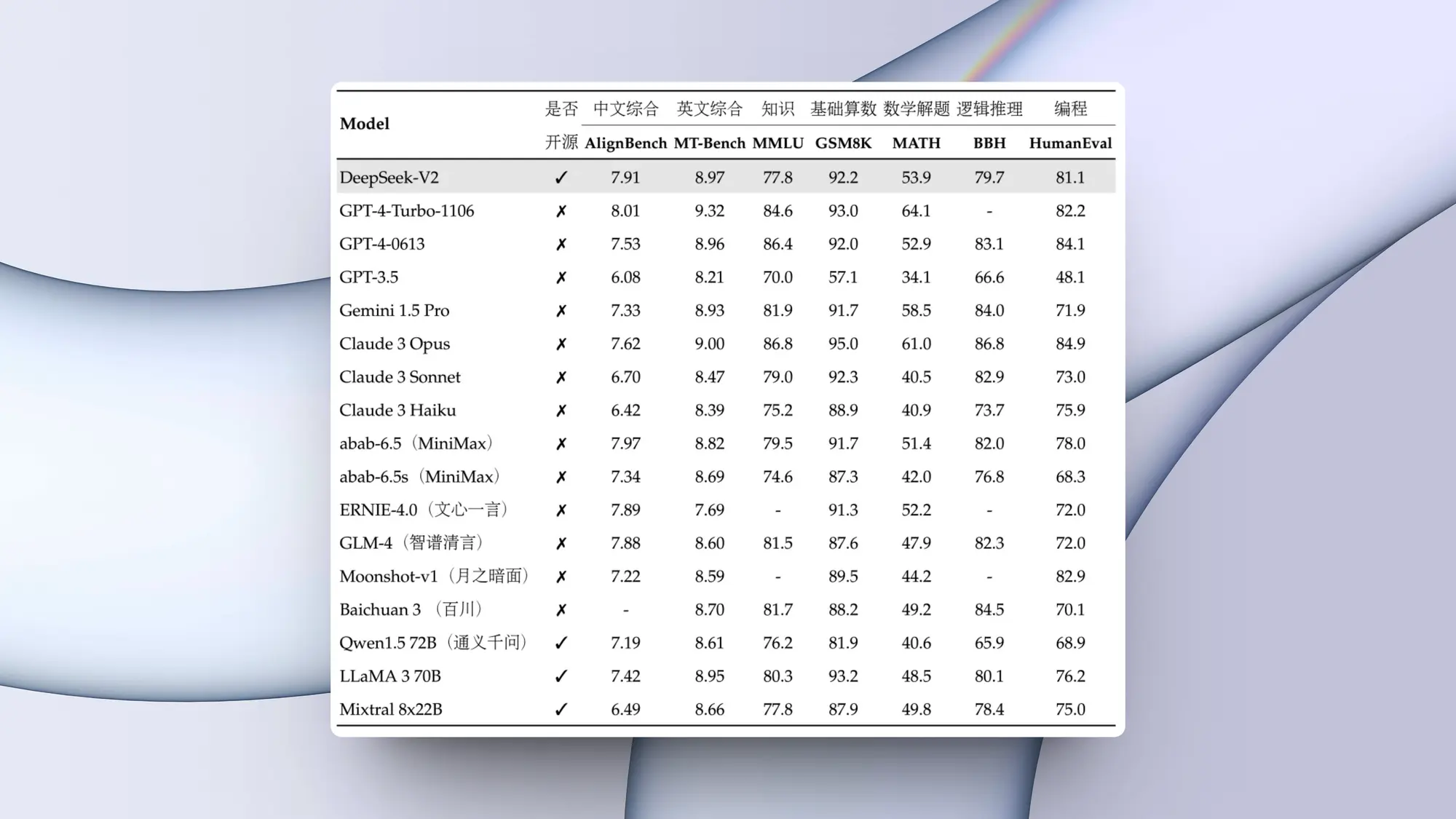

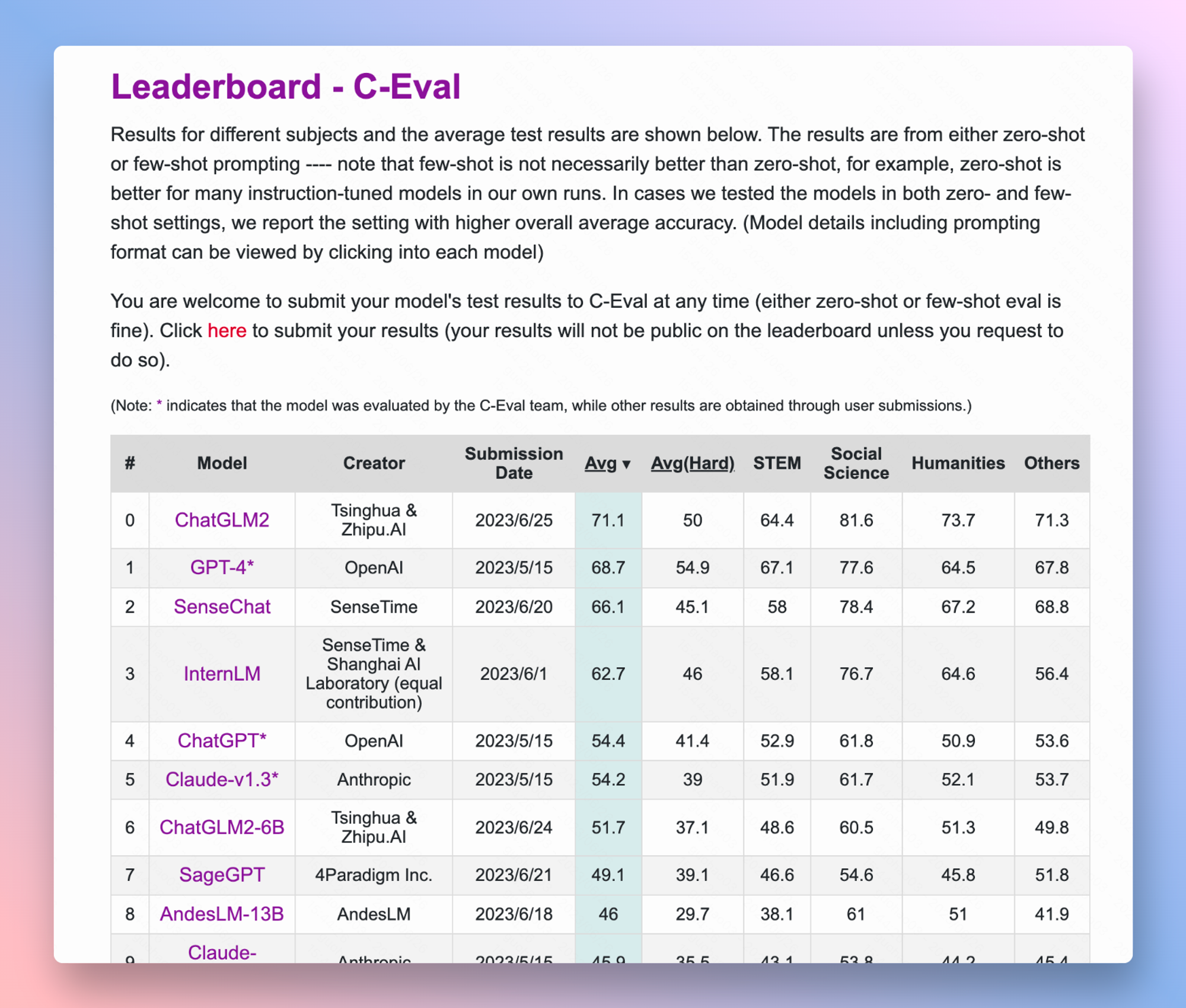

更离谱的是 chatglm2-6b 在leaderboard – c-eval这个测试的评分居然超过了 gpt-4 。推测可能是因为国内经常用c-eval和gaokao这两个数据集测评大模型,其实这些测试集都是单项选择题,所以即使是蒙都能蒙 25 分,而且有可能测试数据集在训练的时候就被灌给了模型,相当于开卷考试了才会这样。

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun238376.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重