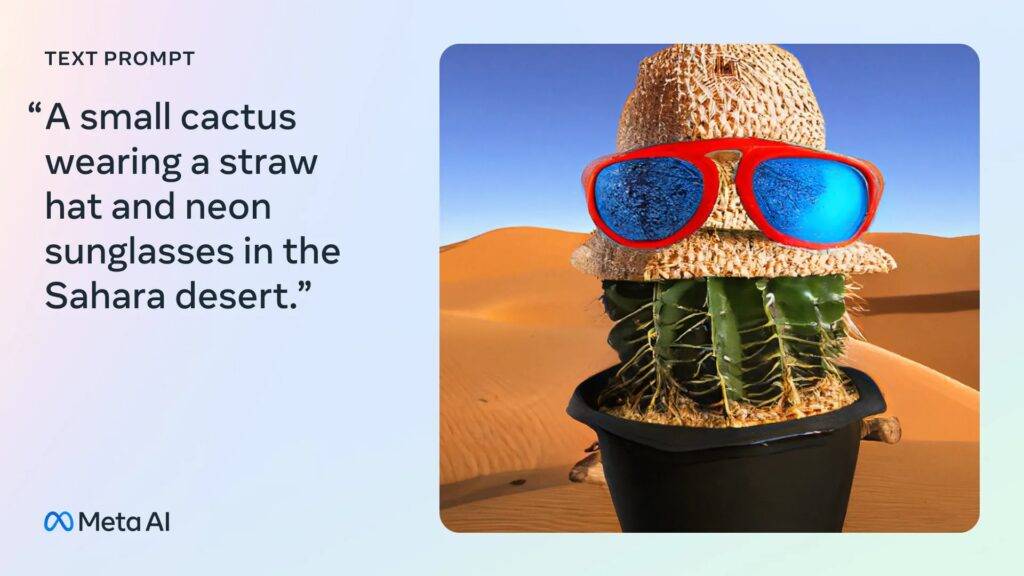

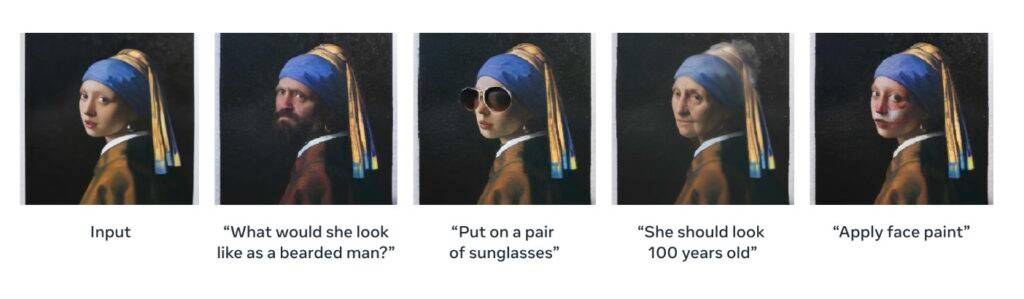

meta 日前推出了一款全新的生成型 ai 模型 — (发音像变色龙 chameleon),具备文本转成图像以及图像转成文本的能力。 meta 表示 是首个经由改良的纯文本语言模型配方进行训练的多模态模型,包含大规模检索增强的预训练阶段以及第二阶段的多任务监督微调(sft)阶段。

根据meta的说法,与以往的transformer-based的方法相比,cm3leon只需要五倍的计算能力和更小的训练数据集。

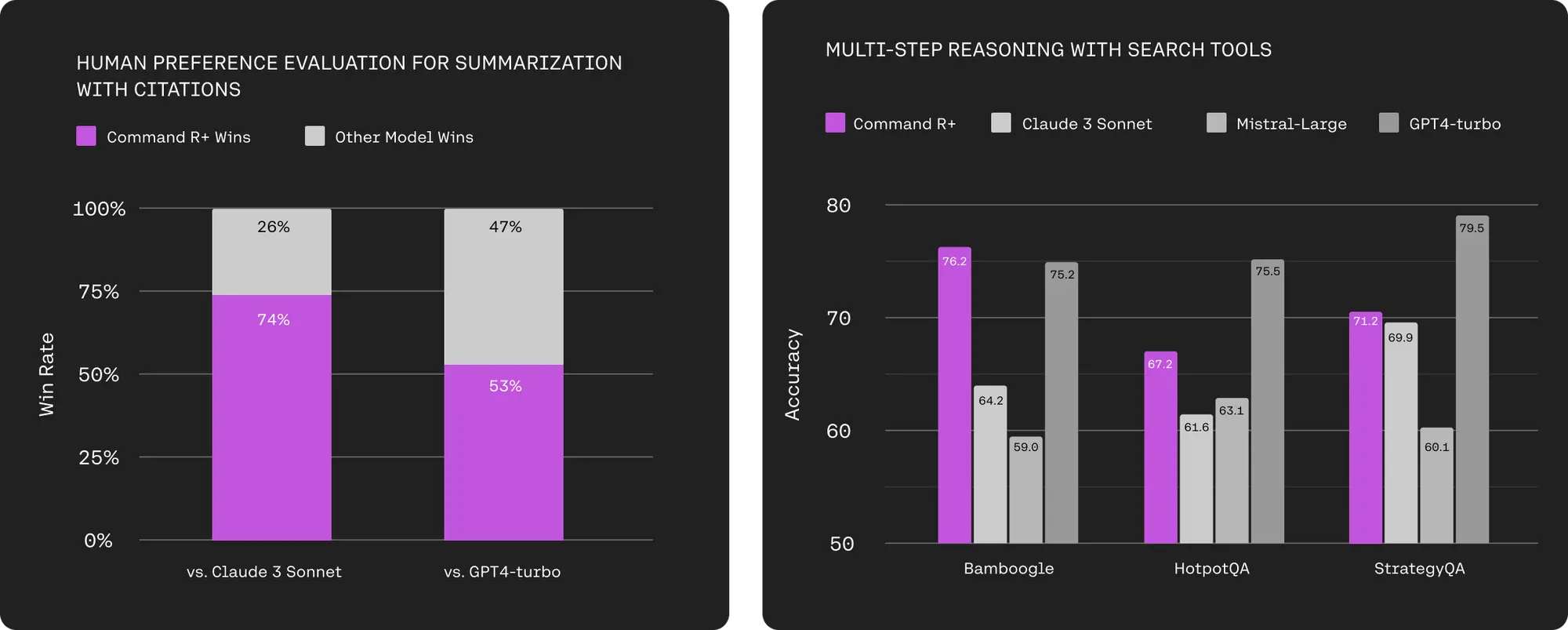

在与最广泛使用的图像生成基准(zero-shot ms-coco)进行比较时,cm3leon获得了 4.88 的 fid (fréchet inception distance)得分,证实了其文本转图像技术超越了 google 的文本转图像模型 parti。

meta 也指出 cm3leon 在广泛的视觉语言任务中表现出色,例如视觉问答和长篇字幕生成。 尽管只在仅含三百亿文本标记的数据集上进行训练,cm3leon的 zero-shot 效能可与在更大数据集上训练的更大型模型看齐。

meta 表示:「我们的目标是创建高质量的生成模型,我们相信 cm3leon 在各种任务上的强大表现是向更高保真度图像生成和理解迈出的一步。 像 cm3leon 这样的模型最终可以帮助提升创意,并在元宇宙中应用。 我们期待探索多模态语言模型的边界,并在未来释放更多模型。」

原创文章,作者:校长,如若转载,请注明出处:https://www.yundongfang.com/yun243388.html

微信扫一扫不于多少!

微信扫一扫不于多少!  支付宝扫一扫礼轻情意重

支付宝扫一扫礼轻情意重